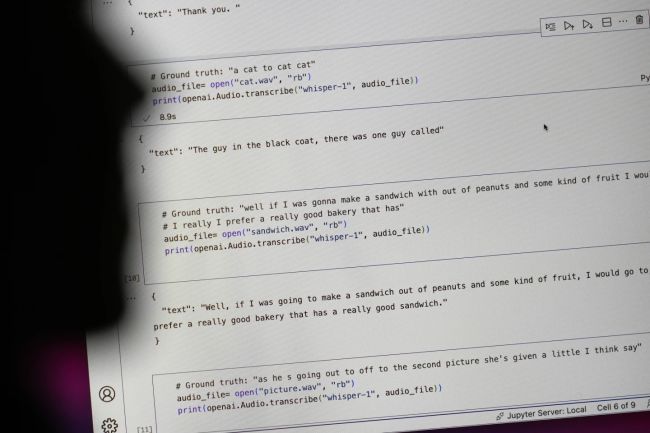

OpenAI، شرکت پیشرو در حوزه هوش مصنوعی، ابزار رونویسی خود به نام ویسپر را به عنوان ابزاری قدرتمند و دقیق معرفی کرده است که میتواند با دقت بسیار بالایی، گفتار انسان را به متن تبدیل کند. اما بررسیهای دقیقتر نشان دادهاند که این ابزار با مشکل جدی تولید اطلاعات نادرست و ساختگی مواجه است.

به گزارش سرویس اخبار فناوری رسانه تکنولوژی تکنا، بر اساس مصاحبه با دهها متخصص در حوزه هوش مصنوعی، ویسپر اغلب قطعاتی از متن را به طور خودسرانه ایجاد میکند یا حتی جملات کاملاً جدیدی را میسازد که در متن اصلی وجود نداشتهاند. این اطلاعات نادرست که در اصطلاح فنی به آنها «توهم» گفته میشود، میتوانند شامل مطالب نژادپرستانه، خشونتبار و حتی اطلاعات پزشکی غلط باشند.

استفاده گسترده از ویسپر در صنایع مختلف، از جمله پزشکی، این مشکل را پیچیدهتر کرده است. با وجود هشدارهای OpenAI مبنی بر عدم استفاده از این ابزار در حوزههای حساس مانند پزشکی، برخی از مراکز درمانی از ویسپر برای رونویسی گفتگوهای پزشکی استفاده میکنند که میتواند خطرات جدی برای بیماران به همراه داشته باشد.

علت اصلی این مشکل، محدودیتهای ذاتی مدلهای زبانی بزرگ مانند ویسپر است. این مدلها بر اساس حجم عظیمی از دادهها آموزش میبینند و میتوانند الگوهای زبانی پیچیده را شناسایی کنند. اما آنها همیشه قادر نیستند بین اطلاعات واقعی و اطلاعات ساخته شده توسط خودشان تمایز قائل شوند. انتشار اطلاعات نادرست میتواند به ایجاد سوءتفاهم و تشدید اختلافات اجتماعی منجر شود. همچنین استفاده از ویسپر در حوزه پزشکی میتواند به تشخیص اشتباه بیماریها و تجویز درمانهای نادرست منجر شود. در نهایت این مشکلات میتوانند به کاهش اعتماد عمومی به فناوری هوش مصنوعی منجر شوند.

برای رفع این مشکل، محققان و توسعهدهندگان باید به دنبال راههایی برای بهبود دقت و قابلیت اطمینان مدلهای زبانی بزرگ باشند. استفاده از دادههای آموزشی با کیفیتتر و متنوعتر میتواند به مدلها کمک کند تا بهتر بین اطلاعات واقعی و اطلاعات ساختگی تمایز قائل شوند. توسعه روشهای دقیقتر برای ارزیابی عملکرد مدلها میتواند به شناسایی و رفع مشکلات کمک کند.

source